Los prompts son las indicaciones que le mandamos a los asistentes de Inteligencia Artificial – como ChatGPT, Microsoft Copilot, Google Gemini, entre otros – para que hagan lo que nosotros queremos. En este artículo revisaremos las principales tácticas que te permitirán aumentar la precisión, consistencia y robustez de los resultados que te entregan estos asistentes.

En primer lugar, hay que entender que estas ideas son para desbloquear aquellos problemas que te cuestan más. Muchas veces prompts sencillos, como “resume esto”, o “mejora la gramática de esto”, son suficientes para lograr nuestro objetivo, pero las siguientes tácticas te permitirán resolver problemas más complejos.

Cuando pidas algo, sigue la siguiente estructura.

La tarea es la acción más básica que necesitas del modelo. Probablemente esto ya lo estabas incluyendo bien, lo importante es complementarlo con los siguientes puntos.

El contexto es la información clave que el modelo necesita para procesar tu solicitud. Piensa en cómo se lo explicarías a alguien que no conoce tu empresa ni tu país, pero sí tu rubro. Aclara términos locales (por ejemplo: “educación media” o escalas de evaluación en Chile), marcas conocidas en tu mercado (ej: “Cristal es una marca líder en el mercado de cervezas”), cuáles son los documentos que estás adjuntando (ej: “Este Excel contiene la información de …”), o la meta que tienes sobre el entregable (ej: “Estas ideas son para aumentar nuestra recordación de marca”).

En el formato debes especificar cómo quieres la salida. Es común pedirlo en formato de tablas, en punteo (bullet points), o en formatos estructurados como XML, JSON, CSV u otros. Además, aclara cualquier expectativa sobre la manera en que quieres la información (“ej: la quiero en una sola palabra o párrafo»).

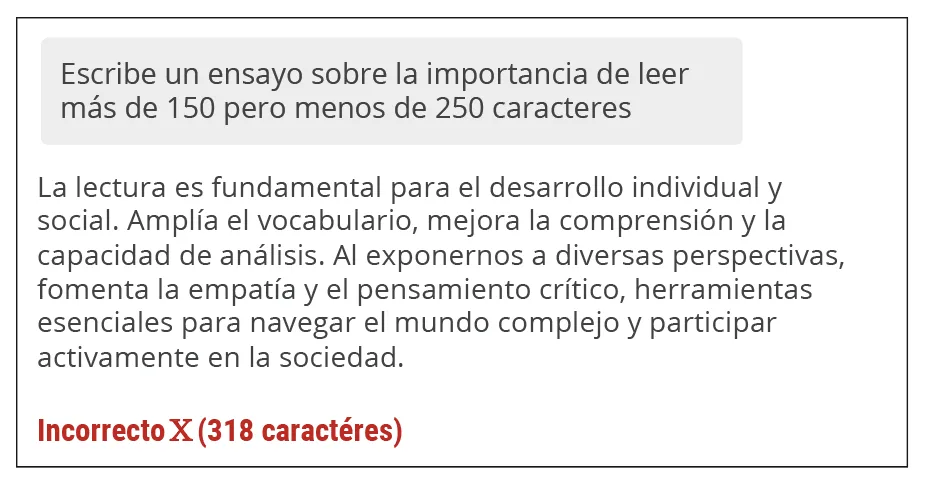

En este punto, ten en cuenta que los modelos de lenguaje (la tecnología detrás de estos asistentes) no verifican la extensión de lo que estás pidiendo, entonces si pides algo con un número específico de caracteres o palabras el texto será similar a algo de aquella extensión, pero puede ser que no lo cumpla.

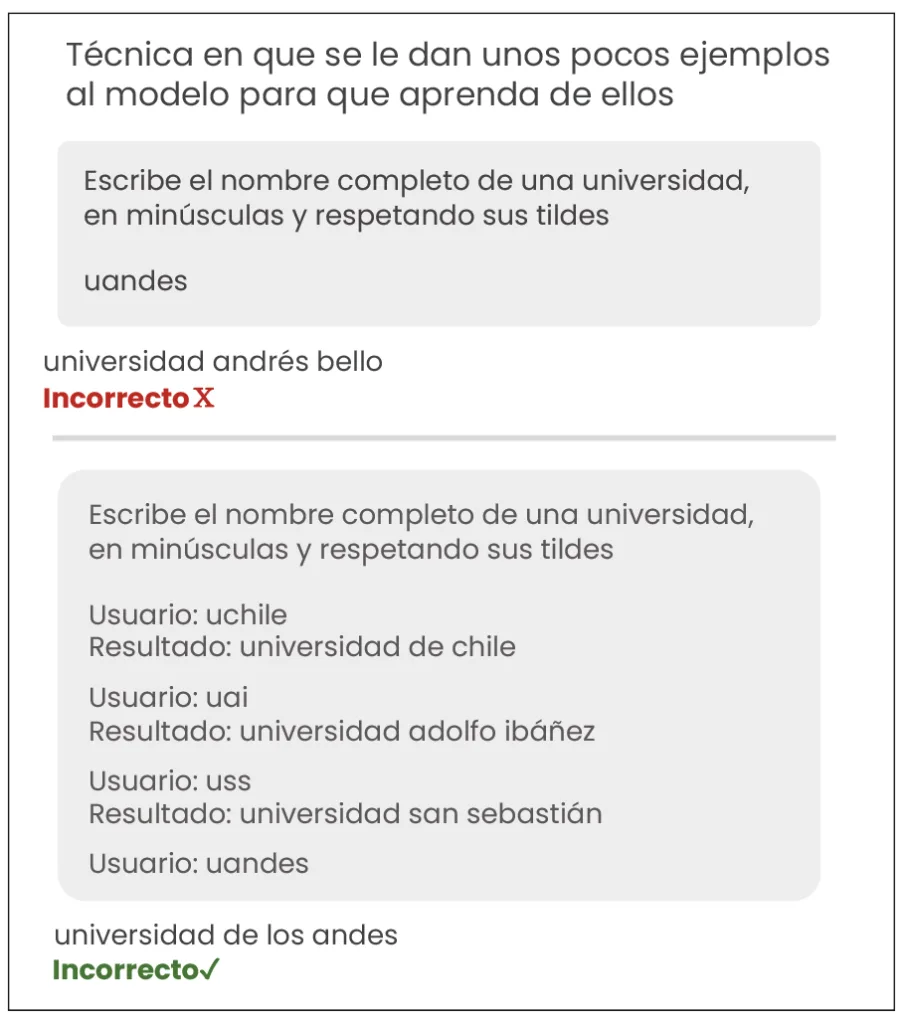

También, es bueno entregarle ejemplos, pues mejora la estructura y además el modelo puede obtener elementos clave del contexto a partir de ellos. En el siguiente ejemplo el modelo no sólo sigue la estructura, sino que también suele equivocarse menos, pues los términos están relacionados a universidades del mismo país, lo cual no se entendía sin los ejemplos.

Con los tips anteriores ya podrás mejorar bastante el rendimiento de tus prompts, pero si aún necesitas más ayuda considera utilizar alguna de las siguientes tácticas:

Pídele al asistente que divida la tarea a realizar en partes. Por ejemplo, con “Antes de entregarme la respuesta, divide este problema en subtareas y resuélvelas una a una.”

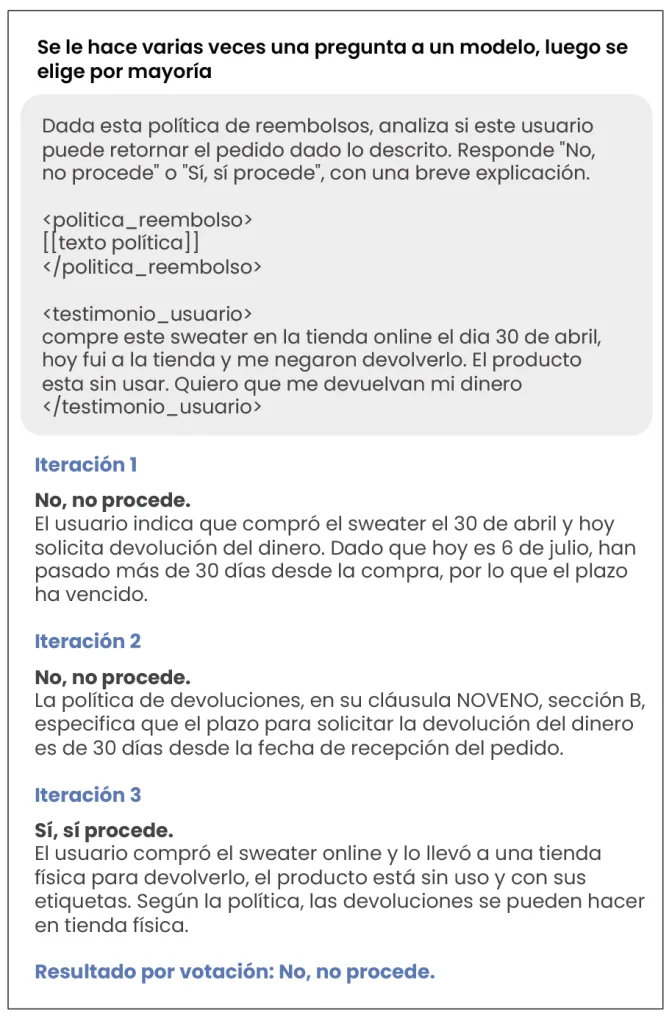

Los modelos de lenguaje tienen respuestas variables. Esto implica que puede pasar que justo la respuesta que tú estás viendo no sea la respuesta más correcta ni la más común. Esto es particularmente importante cuando quieres que la IA te entregue una recomendación.

Para gestionar esto, puedes pedirle el mismo prompt pero en varios chats distintos para así ver si es consistente en su respuesta.

En este ejemplo, se le pidió una evaluación en base a una política de reembolsos, y en 2 de 3 ocasiones determinó un resultado, ¿habría sido correcto tomar la decisión con sólo una de las iteraciones?

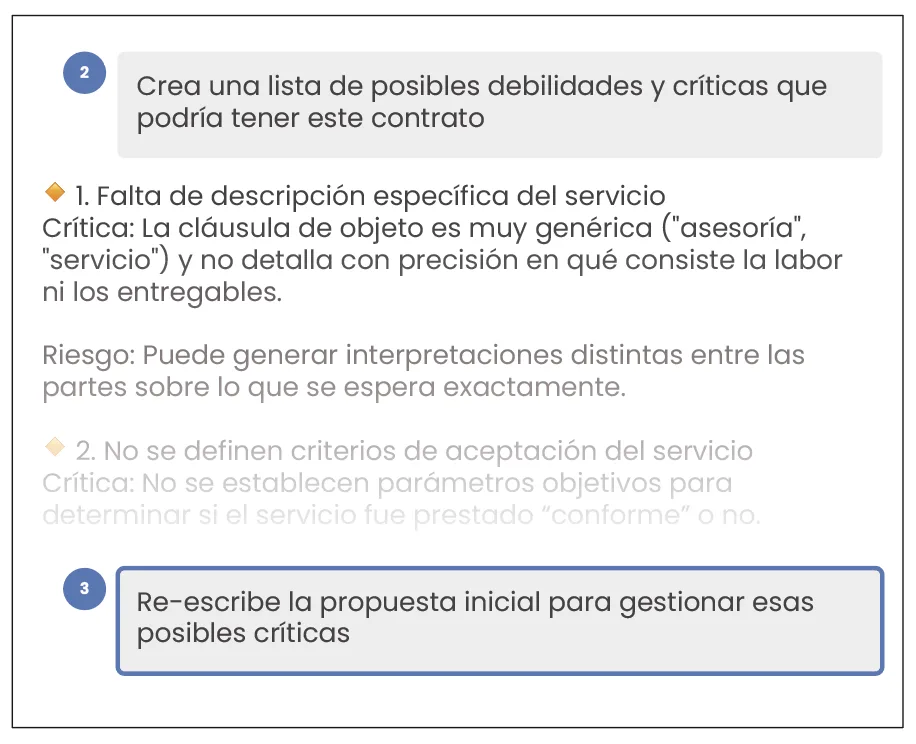

Esta es una técnica que te permite mejorar el resultado a través de inducir que el modelo critique su respuesta original. Para ello debes comenzar con una tarea, luego pedir que la critique y, finalmente, que vuelva a contestar con lo anterior.

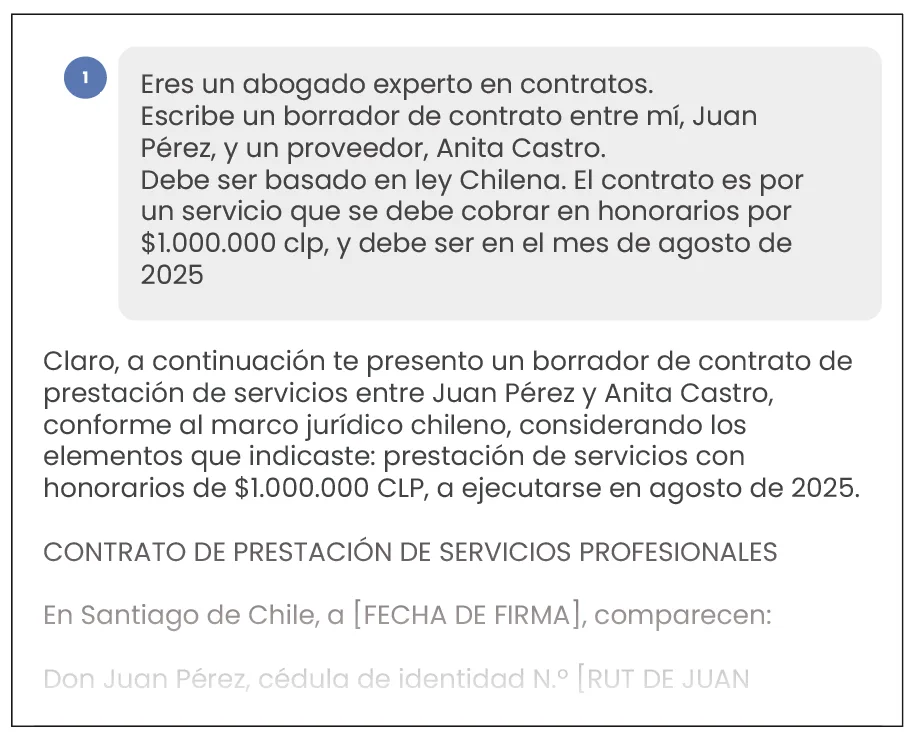

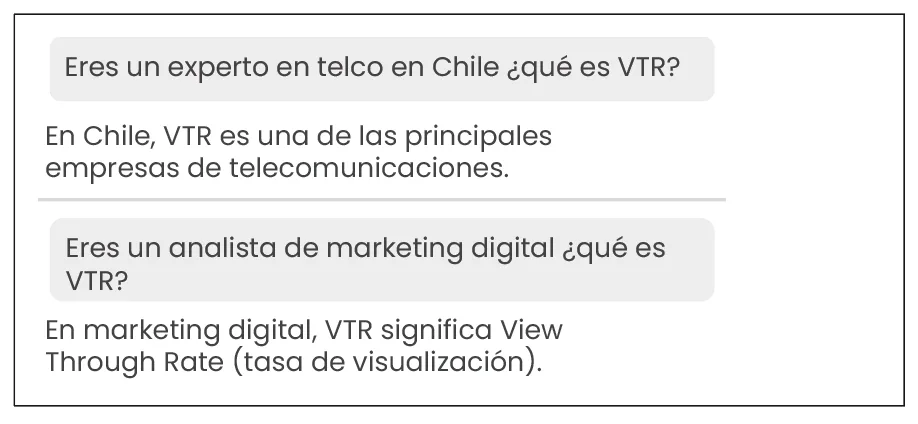

Si has visto alguna de estas guías antes seguramente te has encontrado con consejos como que le des un rol. Por ejemplo “eres un analista de datos”, “eres un copywriter”. Ponerle un rol cambia qué responde y el tono, porque aumenta la probabilidad de responder en relación a la disciplina mencionada. Úsalo cuando tengas una audiencia o disciplina específica.

Por ejemplo, en nuestro podcast semanal “Inteligencia Artificial para los Negocios”, hablamos con Tomás Gómez, quien es Director de Innovación en Extend Comunicaciones, y nos contó cómo en su consultora de comunicación estratégica el darle un rol permite que el modelo capte mejor la industria del cliente. Es decir, cumple una función similar a la del contexto.

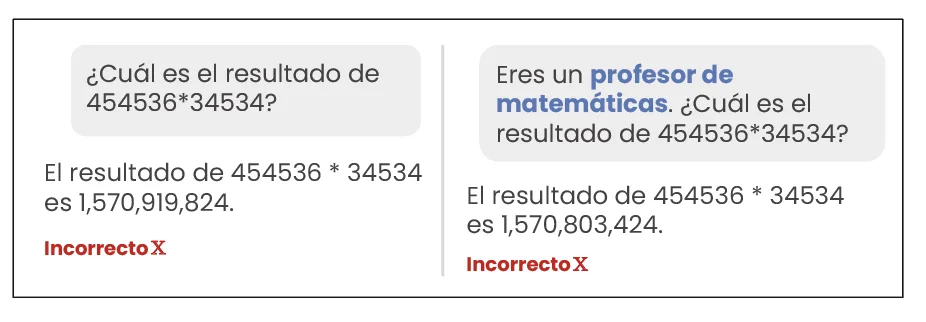

Sin embargo, no esperes que “soy profesor de matemáticas” arregle la aritmética u otros errores relacionados a la precisión del modelo: el rol modifica la personalidad y estilo, pero no garantiza la exactitud en cálculos u otros hechos duros.

En resumen: El rol sí afecta la voz y personalidad, pero en la mayoría de las ocasiones no aumenta la precisión del modelo. Google recientemente le empezó a llamar a esto “Persona”, lo cual nos parece una manera más adecuada de reflejar su verdadero rol.

Autores: